事情还要追述到百度百家号第二次改版的时候,那时候改版把“百度搜索资源平台”后台权限也改了,从什么日收录啥的权限给我从原来的 200 条变成了 10 条,想想也随他,反正我向来随缘。再后来某一天我发现从百度搜不到我的站了,site 一看跟之前一样还有好几万,但是没有任何展示。

不知不觉已经过了这么多年,后来百度还改了 sitemap 形式,索引型不予处理,且若存在索引型 sitemap,将不允许提交新文件,为此还给百度单独生成一个 sitemap 文件。

期间呢我也反馈过,重新提交过,百度呢虽然会在 48 小时内回复,但很明显是拖着你,因为回复的从来都不是人,只是自动延时回答而已,让你网站要合规,内容要优质之类的话。

得,反正呢,这两年百度也没有来源,那你还索引个屁哦,占用我服务器资源。而且现在很多站长都说微软 Bing 来源都要比百度多了,加上 AI 的使用越来越多,现在还有几个人用百度?直接屏蔽算了。

百度爬虫UA

| User-Agent 名称 | 中文说明 |

|---|---|

Baiduspider | 百度通用网页爬虫,用于抓取网页内容 |

Baiduspider-image | 百度图片爬虫,专门抓取网页中的图片链接 |

Baiduspider-video | 百度视频爬虫,用于抓取视频相关页面 |

Baiduspider-news | 百度新闻爬虫,用于抓取新闻类内容 |

Baiduspider-favorite | 百度收藏夹爬虫,抓取用户收藏的网页 |

Baiduspider-web | 百度新版网页爬虫,用于抓取普通网页内容 |

Baiduspider-cpro | 百度联盟广告爬虫,用于广告系统抓取 |

Baiduspider-ads | 百度广告爬虫,抓取广告相关页面 |

Baiduspider-app | 百度移动应用爬虫,抓取移动应用相关页面 |

Baiduspider-sitemap | 百度站点地图爬虫,用于抓取 sitemap 文件 |

Baiduspider-image2 | 百度第二代图片爬虫,更新版的图片抓取工具 |

Baiduspider-zhidao | 百度知道爬虫,抓取百度知道平台内容 |

Baiduspider-zhidao-image | 百度知道中的图片爬虫 |

Baiduspider-zhidao-video | 百度知道中的视频爬虫 |

Baiduspider-zhidao-news | 百度知道中的新闻爬虫 |

Baiduspider-zhidao-favorite | 百度知道中的收藏夹爬虫 |

Baiduspider-zhidao-web | 百度知道中的网页爬虫 |

Baiduspider-zhidao-cpro | 百度知道中的广告爬虫 |

Baiduspider-zhidao-ads | 百度知道中的广告爬虫(另一种写法) |

Baiduspider-zhidao-app | 百度知道中的移动应用爬虫 |

Baidu-YunGuanCe | 百度云观测爬虫,用于网站监控和性能分析 |

Baidu-YunGuanCe-V2 | 百度云观测第二代爬虫 |

Robots 规则分享

# 屏蔽所有百度相关爬虫(包括子爬虫)

User-agent: Baiduspider

Disallow: /

User-agent: Baiduspider-image

Disallow: /

User-agent: Baiduspider-video

Disallow: /

User-agent: Baiduspider-news

Disallow: /

User-agent: Baiduspider-favorite

Disallow: /

User-agent: Baiduspider-web

Disallow: /

User-agent: Baiduspider-cpro

Disallow: /

User-agent: Baiduspider-ads

Disallow: /

User-agent: Baiduspider-app

Disallow: /

User-agent: Baiduspider-sitemap

Disallow: /

User-agent: Baiduspider-image2

Disallow: /

User-agent: Baiduspider-zhidao

Disallow: /

User-agent: Baiduspider-zhidao-image

Disallow: /

User-agent: Baiduspider-zhidao-video

Disallow: /

User-agent: Baiduspider-zhidao-news

Disallow: /

User-agent: Baiduspider-zhidao-favorite

Disallow: /

User-agent: Baiduspider-zhidao-web

Disallow: /

User-agent: Baiduspider-zhidao-cpro

Disallow: /

User-agent: Baiduspider-zhidao-ads

Disallow: /

User-agent: Baiduspider-zhidao-app

Disallow: /

User-agent: Baidu-YunGuanCe

Disallow: /

User-agent: Baidu-YunGuanCe-V2

Disallow: /

# 通用规则:适用于所有其他搜索引擎(如 Google、Bing、Yandex 等),同时屏蔽搜索,防止恶意搜索被收录,把WP后台也顺便屏蔽下。

User-agent: *

Disallow:

Disallow: /?s=*

Disallow: /wp-admin/

Disallow: /wp-includes/

# 提供站点地图,帮助搜索引擎更好地抓取网站内容,记得改成自己的。

Sitemap: https://www.dujin.org/sitemap.xml更新 robots.txt 文件后,如果有其他缓存,比如 CDN 或者其他缓存,也更新一下。

防火墙拦截百度

搜索引擎会不会遵守 robots 规则这完全取决于搜索引擎的善意以及其编程是否遵循这些标准。大家都说大厂会遵守,但是多加一层防护总是没有啥问题的。

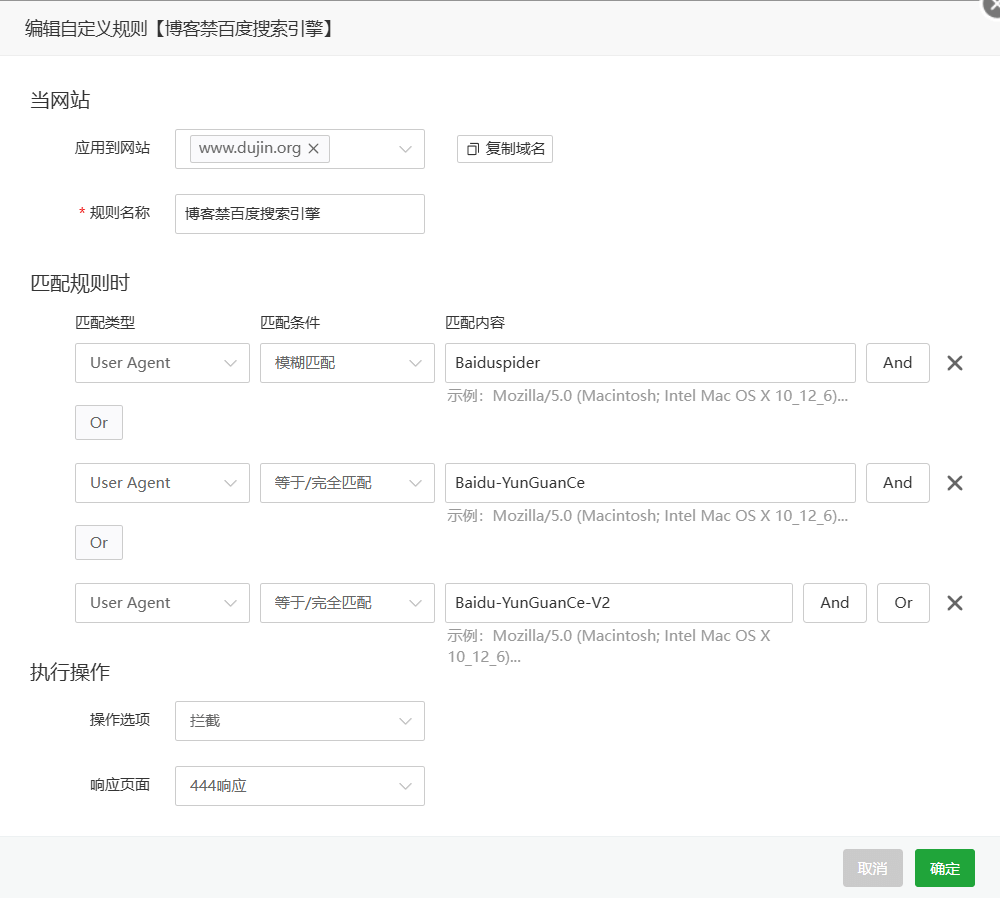

由于 Baiduspider 我用的是模糊匹配,所以就只加这1个,再补充两个别的。

缙哥哥

缙哥哥

![缙哥哥常用运行库下载汇总[2019.1更新]](https://img.dujin.org/images/windowsyunxingku.jpg)

评论前必须登录!

注册